最近では gpt-oss など、実用的な LLM が少し高性能なPCで(なんとか)動かせるようになってきました。ここで A5:SQL Mk-2 の AI として Ollama, LM Studio, Lemonade-Server などのローカルAI を使用するときの注意事項を記載します。

1.できるだけ賢いモデルを使用する

当然ですが、できるだけ賢いモデルを使用します。(2025/11 時点ならば) gpt-oss:20b あたりがかなり良いように思えます。gpt-oss:20b を使用するときは VRAM が 16GB 以上のGPUが推奨されます。

2.最大コンテキスト長を指定する

ローカルAI用のソフトウェアは多くの場合デフォルトで最大コンテキスト長が 4Kトークン程度に設定されています。最大コンテキスト長はAIが一度に扱えるトークン数、つまり文章の長さを表します。A5:SQL Mk-2 はAIチャット機能でもデフォルトでカレントスキーマ全体のCREATE TABLE 文をシステムプロンプトとしてLLMサービスに渡します。このためシステムプロンプトがすぐに4Kトークンを超えてしまい、チャット機能が破綻してしまいます。(正しくSQLを生成できなかったり、エラーになるなど)

設定すべき最大コンテキスト長はおおよその目安として、テーブル数×300トークン程度と考えると良いと思います。(使用するテーブル群によって増減します)

100 テーブルほどのシステムならば、32K 程度を指定すればよいことになります。

各ローカルAIにおいて、設定個所を記載します。

2.1 Ollama

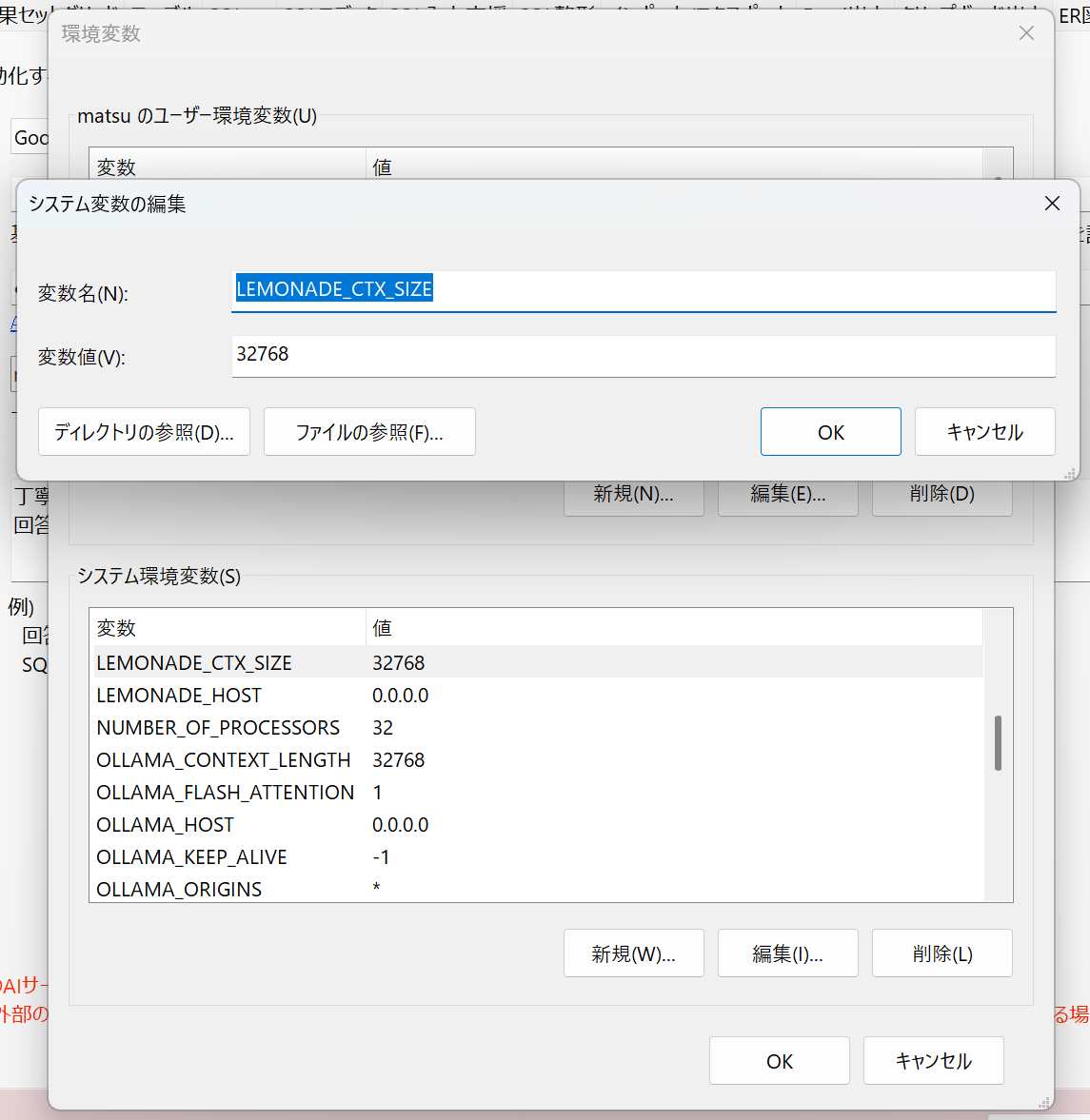

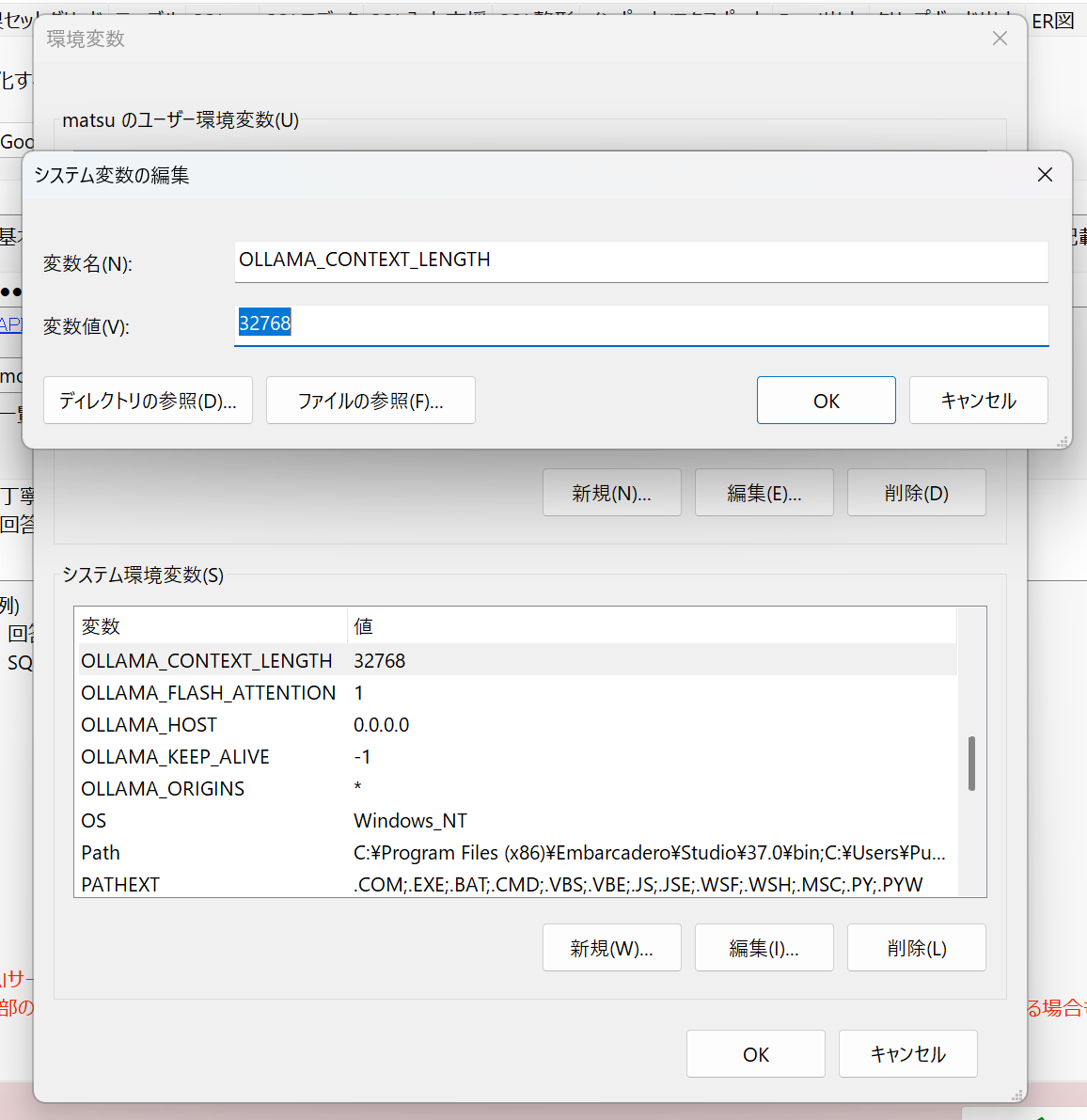

Ollama では環境変数 OLLAMA_CONTEXT_LENGTH に指定します。32K を指定する場合は、 32768 を指定します。

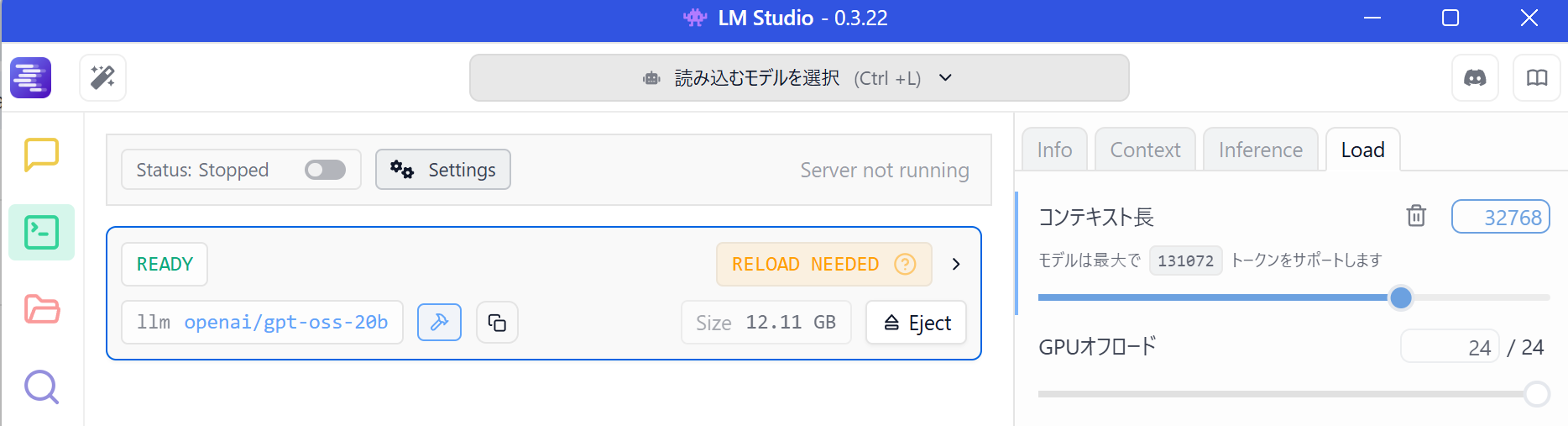

2.2 LM Studio

LM Studio ではモデルごとの設定で指定します。開発者のタブ(緑色のターミナルアイコン)で右上のほうにある「コンテキスト長」で指定します。32K を指定する場合は、 32768 を指定します。

2.3 Lemonade-Server

Lemonade-Server では環境変数 LEMONADE_CTX_SIZE に指定します。32K を指定する場合は、 32768 を指定します。